LibreNMS – backups con Oxidized.

Si cuentas con una red con más de dos dispositivos (router o switch), debes considerar realizar respaldos de manera automatizada a esos equipos, está de más decir que también tenemos que monitorear el comportamiento de estos equipos. Podemos monitorear valores tales como CPU, memoria, estado de las interfaces de red y cantidad de tráfico que pasa por estas, esto es solo por mencionar algunos de los objetos disponibles en un equipo de red.

Sorpresa, todo esto se puede hacer con LibreNMS.

Esta plataforma de monitoreo es un fork de Observium el cual cambio su modo de distribución a uno más cerrado y esto causo que usuarios como YO se movieran a LibreNMS. Recuerdo haber usado un paso a paso de cómo mover la data de un software al otro.

En esta entrada nos saltaremos la parte donde instalamos LibreNMS, en la página del proyecto oficial se puede encontrar esta información.

Oxidized – https://github.com/ytti/oxidized

Como dice su README en GitHub, este es un intento de reemplazar RANCID, en mi opinión este proyecto ha logrado su cometido, mi experiencia con RANCID no fue la más hermosa o placentera.

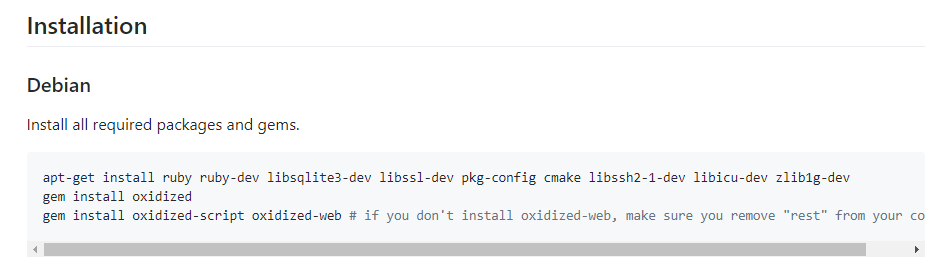

Debian es la distribución en la cual está instalado LibreNMS, en la sección de instalación tienen varias distros, FreeBSD y Docker. Los pasos de instalación de Debian aplican para Ubuntu.

Cuando toco instalar oxidized-web, este fallaba y al final pude determinar que faltaba g++, cuando instale Debian seleccione el mínimo de paquetes, lo extraño fue que también paso lo mismo cuando realice la misma instalación en Ubuntu.

Configurando Oxidized –

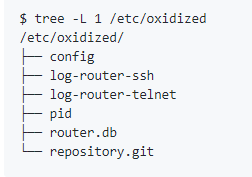

Una vez instalado los tres componentes, podemos proceder a generar una configuración por defecto la cual podemos editar más adelante. Es recomendado no ejecutar Oxidized como root, debemos crear una cuenta para este servicio.

useradd oxidized

Luego ejecutamos oxidized una vez para que sea creado el directorio y en este los archivos necesarios, aunque no usaremos algunos de ellos.

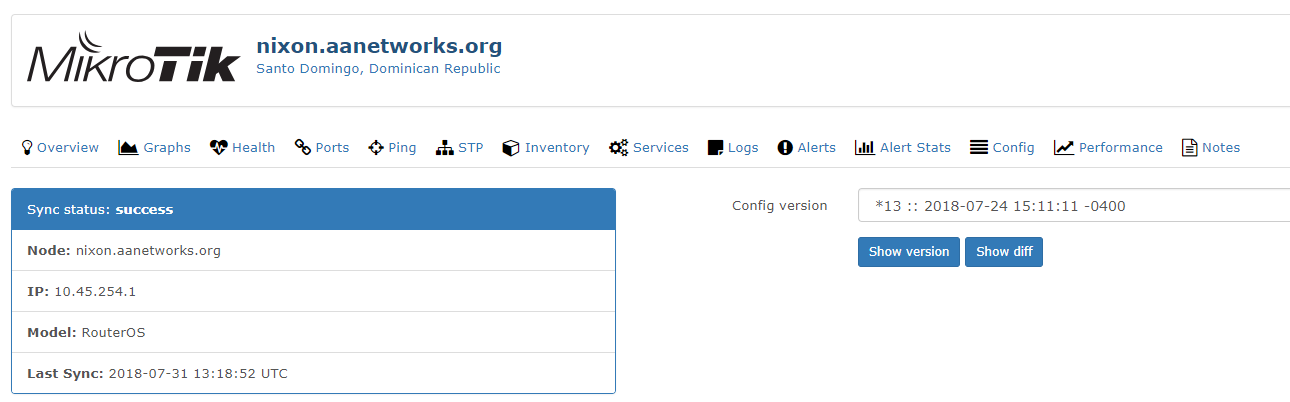

Los Outputs son una parte esencial de la configuración, debemos seleccionar Git para contar con la funcionalidad de versiones dentro de LibreNMS.

Aquí un ejemplo de configuración para Oxidized que funciona en LibreNMS, este es el usado en mi entorno actualmente.

https://gist.github.com/aredan/8e44cb0485d196020472c9c870f1a60c

En router.db no necesitamos colocar equipos, la integración de LibreNMS se encarga de eso y para que esta funcione debemos decirle a Oxidized cuál es la URL del API y crear un usuario, al mismo usuario debemos asignarle un Token para ser usado desde Oxidized.

Oxidized como servicio –

Muchas veces instalamos componentes que necesita inicializar con el sistema y este se encarga de colocar lo necesario, ya sea en init.d o en system.d, en el caso de Oxidized debemos hacerlo nosotros.

https://github.com/ytti/oxidized#extra

Para este momento debemos tener un Oxidized configurado y corriendo como servicio, ya que la manera de acceder estos respaldos será usando LibreNMS, podemos dejar oxidized-web escuchando solo en 127.0.0.1 siempre y cuando ambas plataformas están instaladas en el mismo equipo.

Configurando LibreNMS –

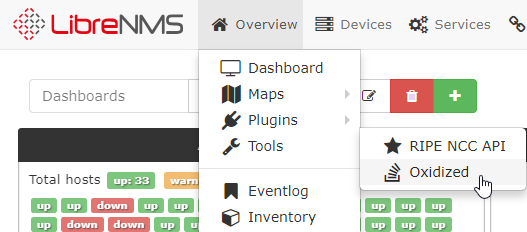

Usando la opción de configuración mediante Global Settings -> External Settings no funciono, ni siquiera presento errores en el log de LibreNMS, cuando introduje la configuración directamente en config.php, automáticamente apareció la opción de Oxidized en Overview -> Tools. Pasados unos minutos ya podía ver intentos de conexión desde la maquina con LibreNMS/Oxidized a los equipos de red que fueron definidos en la configuración de Oxidized.

$config['oxidized']['enabled'] = TRUE;

$config['oxidized']['url'] = 'http://127.0.0.1:8888';

$config['oxidized']['features']['versioning'] = true;

$config['oxidized']['group_support'] = true;

$config['oxidized']['default_group'] = 'default';

$config['oxidized']['reload_nodes'] = true;

$config['oxidized']['group']['os'][] = array('match' => 'nxos', 'group' => 'nxos');

$config['oxidized']['group']['os'][] = array('match' => 'ios', 'group' => 'ios');

$config['oxidized']['group']['os'][] = array('match' => 'fortigate', 'group' => 'fortinet');

$config['oxidized']['group']['os'][] = array('match' => 'routeros', 'group' => 'routeros');

En las últimas cuatro líneas están definidos los equipos que quiero que LibreNMS compare contra Oxidized, por lo menos así lo entendí yo.

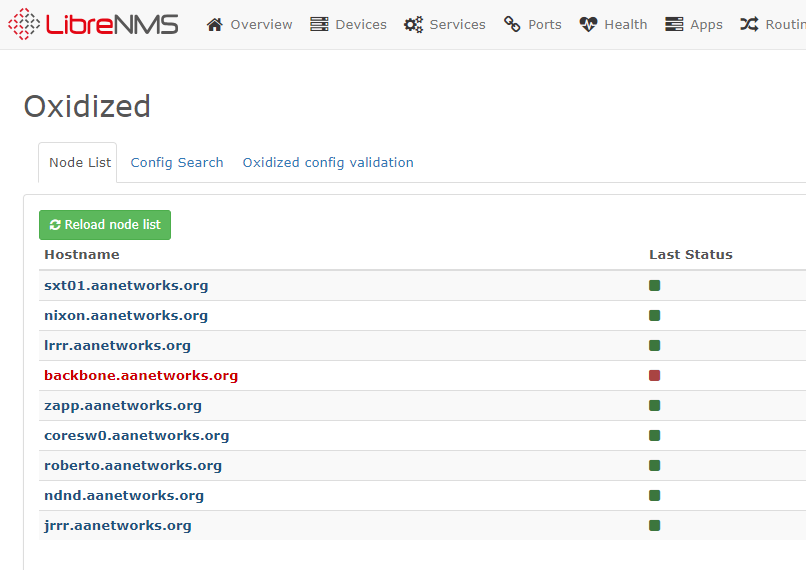

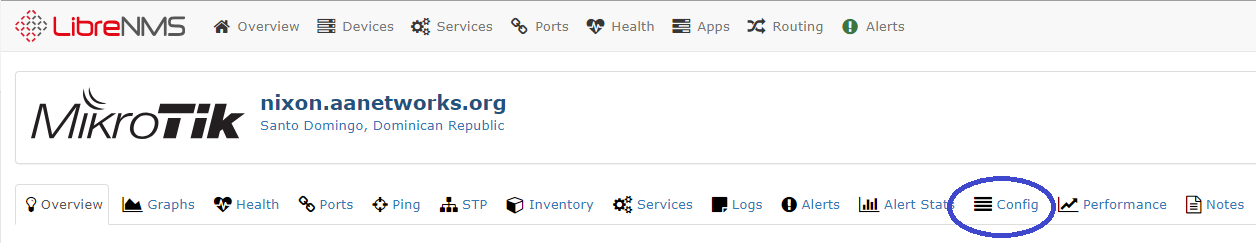

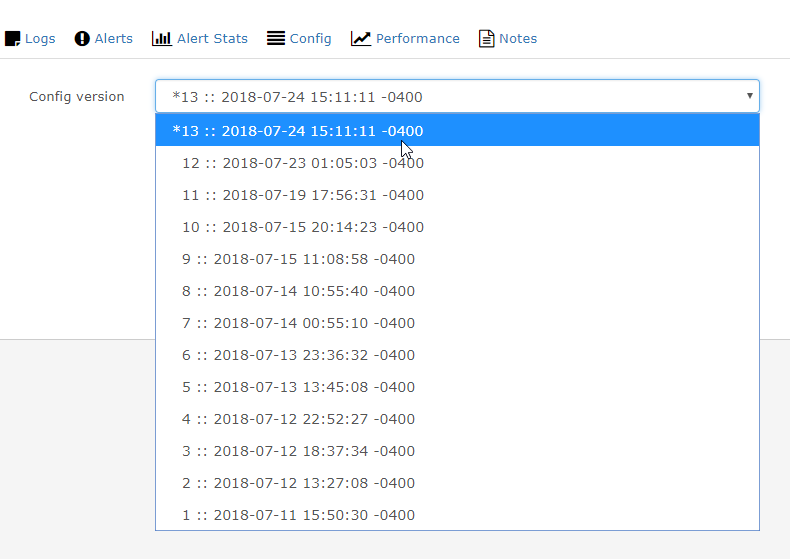

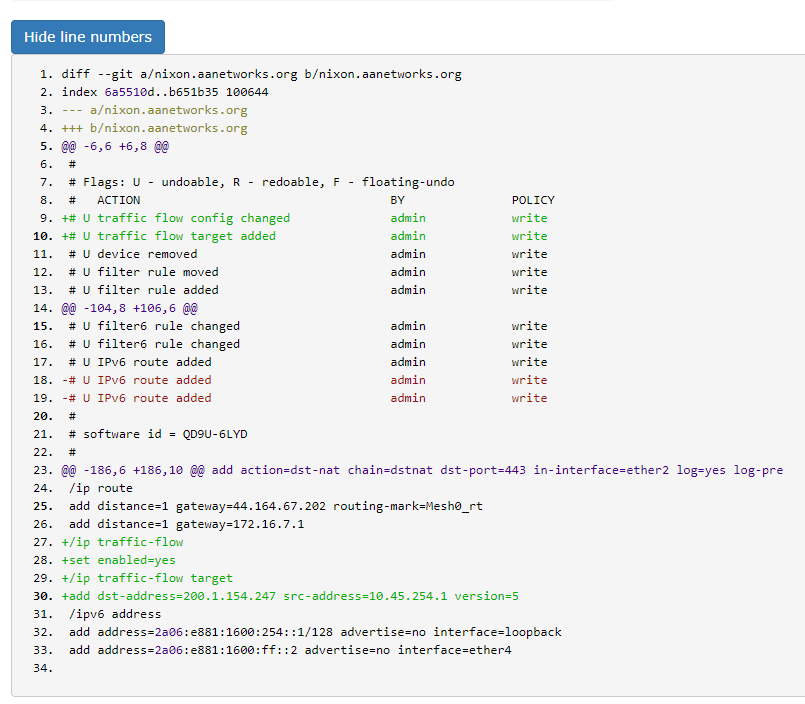

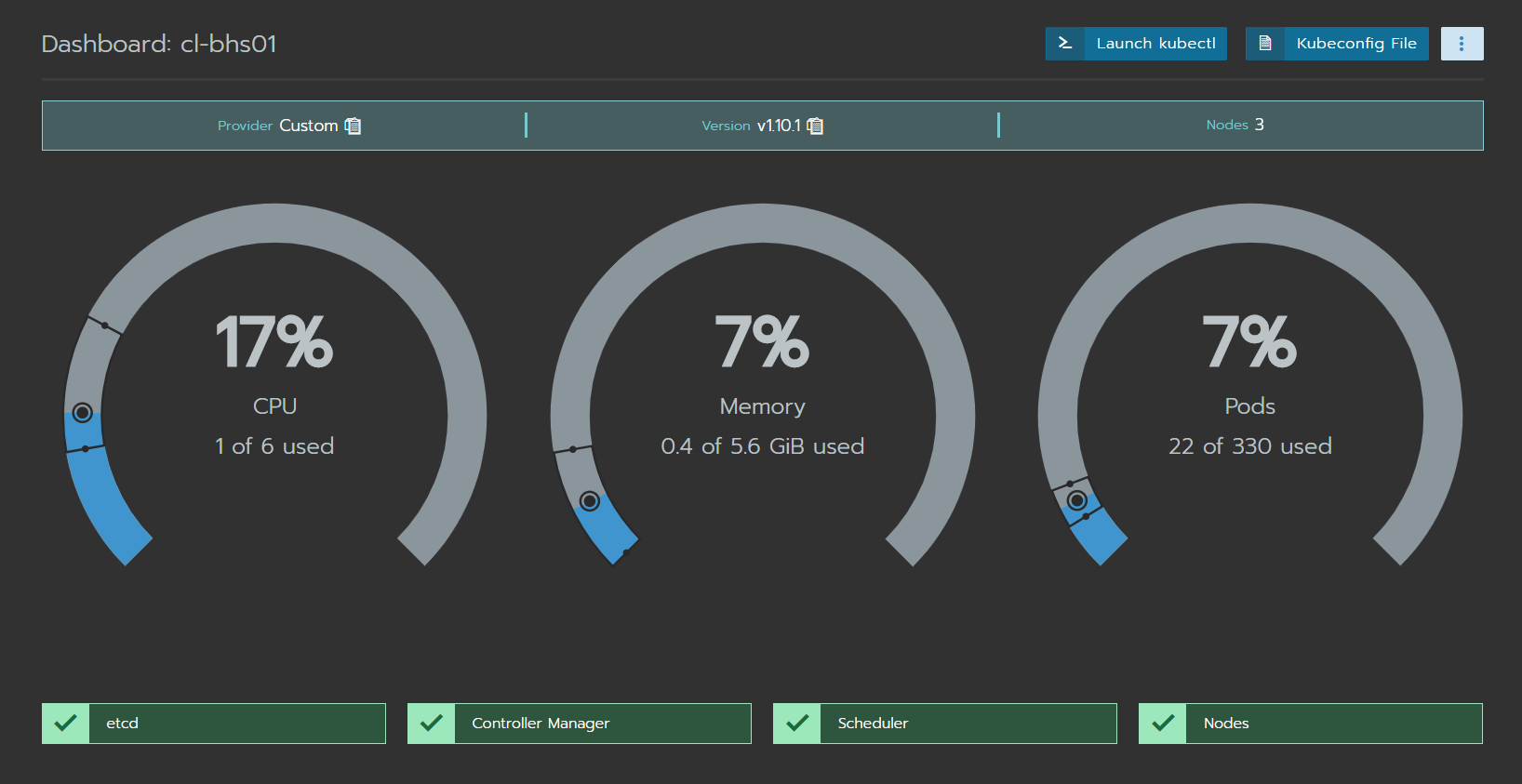

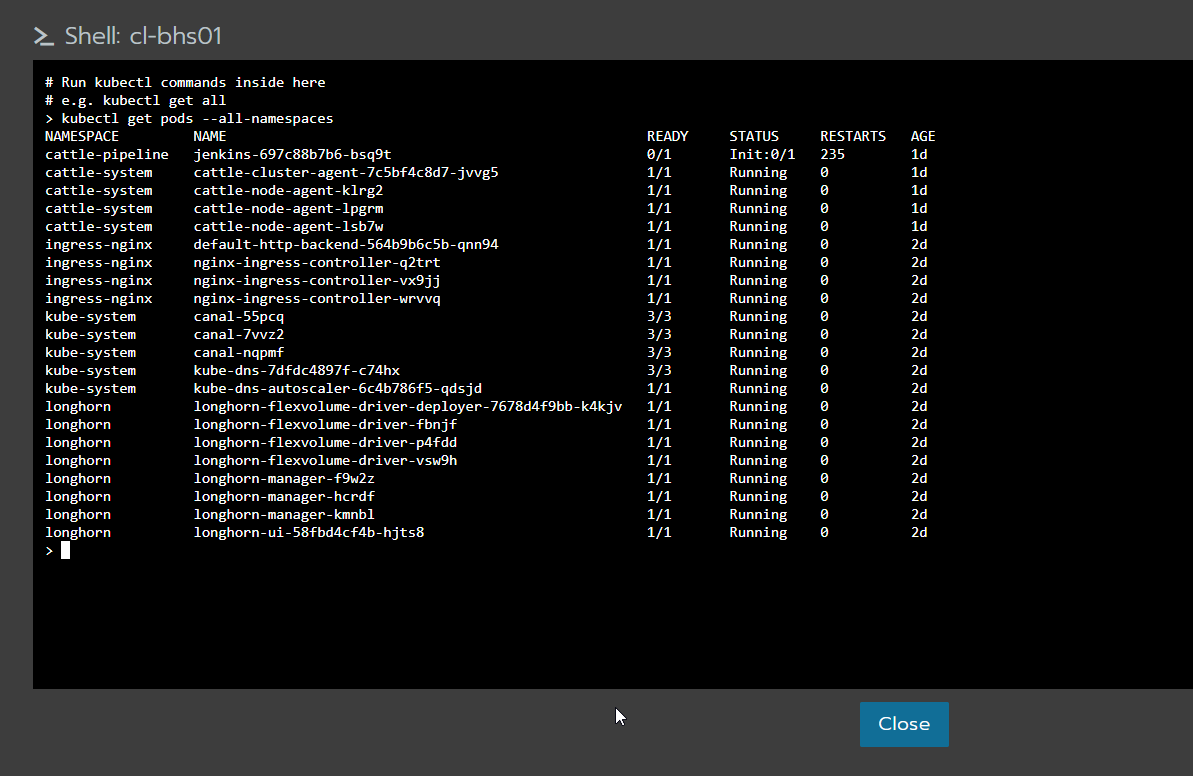

Aquí algunas capturas de pantalla de LibreNMS accediendo a los respaldos realizados por Oxidized.