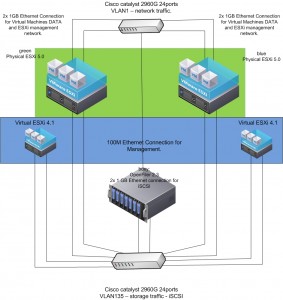

El primero paso para un LAB de VMware que nos permita adentrarnos en las opciones de gama alta de esta suite debe contar como mínimo con 2 host (Hypervisors) en este caso serian 2 Servidores ESXi idénticos o que la diferencia en hardware sea mínima. Lo normal es hacer una lista con componentes que estén en el HCL o que se hayan reportado como compatibles, para esto recomiendo el HCL hosteado por vm-help.com (http://www.vm-help.com//esx40i/esx40_whitebox_HCL.php), esta lista se inicio con ESX4 y ESXi4 pero como el HCL ha tenido muchos cambios, mas y mas hardware esta siendo aceptado en dicha lista.

A continuación describiré como termine decidiendo que hardware utilizar para montar el LAB de VMware.

El motherboard como se sabe, es una parte importante de todo equipo que se pretende usar como servidor, en virtualización este componente no pierde su importancia ya que varias funcionalidades primero deben ser soportadas allí.

Como el factor precio es importante, para mi la mejor manera fue comparando el precio y luego buscando en el HCL si estaba soportado. Así termine comprando un MSI 760GM-E51, este esta en la lista de vm-help y el único inconveniente reportado ha sido la NIC interna que no es detectada por ESXi4 pero si es detectada en ESXi5. http://www.vm-help.com/forum/viewtopic.php?f=13&t=2830

A simple vista este board no aparenta de alto desempeño, pero por el precio pagado y lo brindado, para mi es justo. Este board en amazon.com ronda por los $69.99 y sus especificaciones son mas que suficientes para las tareas que realizaremos en el LAB. http://www.amazon.com/MSI-Computer-Motherboards-760GM-E51-FX/dp/tech-data/B006MCSGZQ/ref=de_a_smtd

Copiado desde amazon.com:

Product Features

CPU: Socket AM3+ Support 64bit AMD FX/ Phenom II X6/X4/X3/X2/ Athlon II X4/X3/X2/ Sempron Processors; Support HyperTransport 3.0; FSB up to 2.6GHz

Chipset: AMD 760G & SB 710 Chipset

Memory: 4x DDR3-1333/1066/800 DIMMs, Unbuffered, Max Capacity up to 32GB

Slots: 1x PCI-Express 2.0 x16 Slot(Support Hybrid CrossFireX); 1x PCI-Express x1 Slot; 2x 3.3V/5V PCI Slots

IDE/SATA: 1x ATA-133 Channel; 5x SATA2 Ports, Support RAID 0/ 1/ 0+1/ JBOD; 1x eSATA2 Port

Form Factor: Micro-ATX

Ports: 12x USB 2.0 Ports(6 rear, 6 by headers); 1x PS/2 Port; 1x VGA Port; 1x DVI Port; 1x HDMI port; 1x eSATA2 port; 1x RJ45 Port; Audio I/O Jacks

Processor, Memory, and Motherboard

Memory Slots: 4

Ports and Connectivity

USB Ports: 12

Free PCI Slots: 1

Cases and Expandability

Size (LWH): 9.6 inches, 2.8 inches, 9.6 inches

Weight: 1.5 pounds

continuara…